| POR DENTRO

DO COMPUTADOR - 9

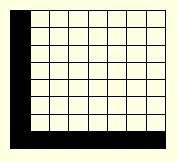

Como se formam as imagens Abaixo:

matriz 8x8 com a letra L

Se

você aprendeu na escola o conceito de matrizes, vai entender mais

facilmente como se formam as imagens no computador. Mas é simples:

peque uma folha de papel quadriculado e recorte, de forma que fiquem oito

linhas, cada uma com oito quadrados. Essa é uma matriz 8x8. Agora,

pinte todos os quadradinhos da primeira coluna da esquerda. Pinte em seguida

os quadradinhos da última linha (o primeiro quadrado já vai

estar pintado). Olhe de longe: você verá uma letra [L]. Se

você aprendeu na escola o conceito de matrizes, vai entender mais

facilmente como se formam as imagens no computador. Mas é simples:

peque uma folha de papel quadriculado e recorte, de forma que fiquem oito

linhas, cada uma com oito quadrados. Essa é uma matriz 8x8. Agora,

pinte todos os quadradinhos da primeira coluna da esquerda. Pinte em seguida

os quadradinhos da última linha (o primeiro quadrado já vai

estar pintado). Olhe de longe: você verá uma letra [L].

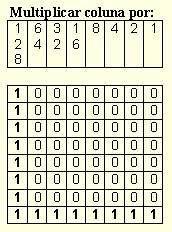

Abaixo: como o micro vê a letra  O

computador faz algo parecido. Imagine que todos os quadrados pintados são

números 1 e todos os que ficaram em branco são números

0. Você terá sete linhas como [10000000] e a última

linha deverá estar como [11111111]. Lembre-se: você terá

portanto um grupo de oito bytes (oito linhas de oito bits cada uma). O

computador faz algo parecido. Imagine que todos os quadrados pintados são

números 1 e todos os que ficaram em branco são números

0. Você terá sete linhas como [10000000] e a última

linha deverá estar como [11111111]. Lembre-se: você terá

portanto um grupo de oito bytes (oito linhas de oito bits cada uma).

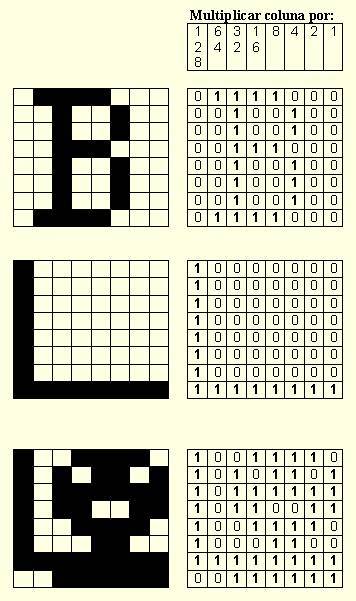

Em cada uma dessas linhas ou bytes, o computador multiplica o último bit da direita por 1, o penúltimo por 2, o antepenúltimo por 4 e assim por diante (multiplicando por 8, 16, 32, 64 e 128), conforme é feito no código binário, e soma todos os números resultantes da linha. Em cada uma das sete primeiras linhas, a soma será 128+0+0+0+0+0+0+0=128, e na última será 128+64+32+16+8+4+2+1 = 255. Assim, a matriz [128,128,128,128,128,128,128,255] equivale àquela sucessão de uns e zeros obtida com o desenho da letra [L] maiúscula no papel quadriculado. Maiores - Bem, com essa matriz 8x8, você não pode representar caracteres muito refinados. Se quiser representar um ideograma chinês, vai precisar no mínimo de uma matriz 16x16 (16 linhas, cada uma com 16 quadradinhos), que nada mais é que quatro matrizes 8x8 agrupadas para formar um quadrado.

Compare a imagem com os mapa de bits à direita... e veja como colocar um ET no seu micro! Os primeiros computadores pessoais eram conhecidos como de 8 bits, pois só conseguiam ler um grupo de oito bits por vez. Já os chips de 16 bits têm 16 posições de leitura, conseguem ler de uma só vez um grupo de 16 bits, já que cada bit vai para uma posição de leitura (a palavra [Oi], citada acima, é lida de uma só vez, portanto). Agora, os chips dos computadores pessoais conseguem ler de uma só vez 32 bits, e alguns mais sofisticados entendem logo 64 bits de uma só vez. O computador

transforma essas séries de números em imagens, refazendo

aquele processo dos quadriculados (embora esta explicação

seja bem simplificada). Um monitor de boa qualidade, por exemplo, permite

uma nitidez de 1000 x 1200 pixels, que são os pontos básicos

que formam a imagem na tela, seu nome vem do inglês picture cell,

célula da imagem. Cada pixel precisa de pelo menos um byte (ou seja,

de oito bits) para reter a informação relativa a cor e brilho).

Uma conta simples mostra que é necessário mais de um megabyte

de informação para se desenhar uma tela. E essa mesma tela

é redesenhada várias vezes por segundo...

|

x5

x5 x10

x10 x16

x16