| INFORMÁTICA FÁCIL:

Ligue

seu micro com o mundo... (26)

Perdido na Web? Se World

Wide Web significa Teia de Alcance Mundial, não estranhe encontrar

uma aranha se arrastando por ali. De fato, o explosivo crescimento da rede

mundial de computadores criou um sério problema para os usuários:

como encontrar a informação desejada, em meio a tantos endereços

eletrônicos, alguns apenas em Daí, poucos anos atrás, começaram a ser montados mecanismos de busca, que verificam milhões de páginas Web por dia em busca de determinadas informações. Esses robôs - pois são mecanismos programados para funções específicas, não importa que sejam apenas software, sem partes mecânicas - foram apelidados de “spiders” (aranhas) ou “wanderers” (vagabundos, errantes, peregrinos). Um dos primeiros serviços a se valer do sistema é o conhecido Yahoo!, que inicialmente era um banco de dados simples, mas - com o crescimento rápido para milhões de páginas em constante alteração - logo precisou de um meio de manter as informações atualizadas. Logo depois, o Lycos (do latim Lycosidae, nome de uma aranha que corre pelo chão para capturar as presas, em vez de fazer teias) fez o mesmo. Mais recentemente, o Altavista passou a usar seu robô Scooter para verificar diariamente 2,5 milhões de páginas. O objetivo não é só encontrar novas páginas ou pesquisar automaticamente páginas que tratem de determinados assuntos, mas também verificar se as páginas já indexadas continuam existindo ou foram movidas para outra posição na rede (por exemplo, até recentemente a Universidade Santa Cecília tinha seu endereço Web atrelado como um sub-endereço no tronco Fapesp, e hoje possui nome-de-domínio próprio. Outro exemplo conhecido dos brasileiros é o caso dos ministérios em Brasília, que nos últimos meses também ganharam endereços específicos na rede). Esses robôs, se forem programas

bem comportados, são praticamente invisíveis: chegam, fazem

suas verificações e se retiram, sem qualquer problema para

os servidores Internet.

Se você usa a Internet, já deve certamente ter passado por páginas Web que registram algo como “Você é o nosso visitante número X” (como já existe na home-page de Internet A Tribuna, por exemplo). Para definir esse número, existem programas acionados automaticamente a cada acesso. Os robôs poderiam ser feitos de forma a não alterar esse contador, ou no máximo causar um pequeno acréscimo no número de visitas às páginas Web registrado nesses contadores de passagem. No caso de um robô disparar inúmeros pedidos de verificação para uma mesma página, ou atuar na forma de paralelismo (quando enviam inúmeros pedidos de informação simultaneamente), causará também tráfego excessivo nos pontos próximos ao seu servidor básico, congestionando as comunicações. Isso pode afetar até mesmo pontos distantes da rede mundial, que precisem trafegar dados por essa área congestionada. Exemplo clássico de robô mal comportado, embora criado com outros objetivos, foi o de um sueco que precisaria viajar por um mês e programou o equivalente a uma secretária eletrônica para responder a todas as mensagens, informando que o tal sueco estaria viajando. Só que ele esqueceu de desligar o recebimento das mensagens dos grupos de debates. Resultado: a cada mensagem de um grupo de debates, a “secretária eletrônica” emitia uma resposta. Pelo sistema desses grupos, cada mensagem recebida pelo grupo é imediatamente repassada a todos os participantes, inclusive o tal sueco. Cuja “secretária eletrônica” recebia a mensagem e respondia de novo, fechando um círculo que quase enlouqueceu o administrador do sistema, até que ele descobrisse a eficiente “secretária” e retirasse o sueco da lista... Solução? - A

orientação que vem sendo dada é que os servidores

Web tenham um arquivo ROBOTS.TXT, onde sejam colocadas restrições

de acesso a serem obedecidas por tais mecanismos, de forma que a presença

do robô num servidor não afete os programas nele existentes.

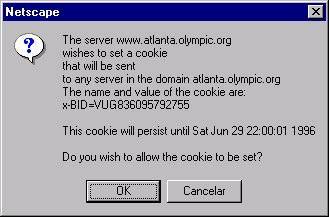

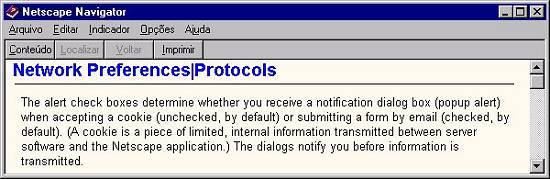

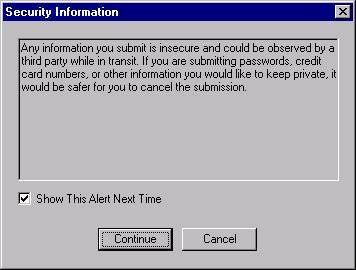

Mas, essa orientação nem sempre é seguida, já Uma nova classe de controles é a dos chamados “cookies”. Os biscoitos (alusão à nova classe de nomes, cujo exemplo mais expressivo é a linguagem Java - que nos Estados Unidos quer dizer “café”) são pequenas informações internas que o seu navegador (browser) pode oferecer mediante solicitação do servidor do software. Browsers como o Netscape possuem um alerta sobre tais pedidos de informação (caso você não tenha desabilitado o alerta), dando-lhe a opção de fornecer ou não o biscoito desejado. Normalmente, essas informações servem para fins estatísticos, mas é opção do usuário decidir se isso significa ou não invasão de sua privacidade... Colaboram nesta série o Renato “Snake” Ferreira Ribeiro, da Snake BBS, e o Christian Rodrigues Barbosa, da Blue Eagle Consulting, encarregado da estruturação de A Tribuna como provedora Internet. |

idiomas

nacionais, outros sem qualquer referência no título para o

assunto tratado?

idiomas

nacionais, outros sem qualquer referência no título para o

assunto tratado?

que

qualquer um pode criar seu robô, até com bons objetivos, porém

funcionando de forma imprópria. Daí, ser este um dos problemas

ainda não solucionados na rede.

que

qualquer um pode criar seu robô, até com bons objetivos, porém

funcionando de forma imprópria. Daí, ser este um dos problemas

ainda não solucionados na rede.